آشنایی با Data Deduplication یا حذف رکوردهای تکراری داده

یادداشت ویراستار: اصل این مطلب در فروردین 1397 نوشته شده بود و در بهمن 1399 دوباره بررسی و بهروز شده است.

Data Deduplication یا حذف رکوردهای تکراری داده اهمیت بسیار زیادی در سرعت ذخیره سازی و واکشی داده دارد. در این مقاله با تکنولوژی Data Deduplication و انواع آن آشنا میشویم و برخی مزایای آن را نام میبریم.

Data Deduplication چیست؟

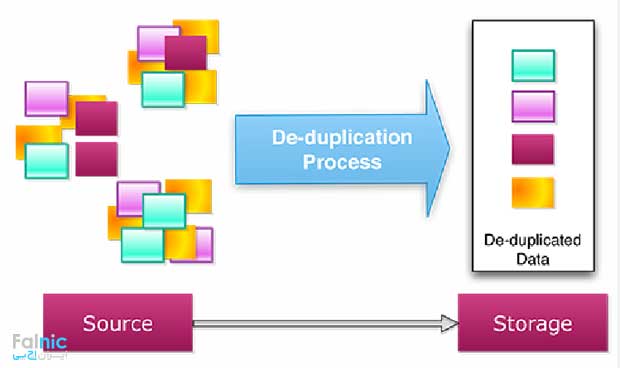

Data Deduplication یا حذف رکوردهای تکراری داده که به صورت Dedupe هم شناخته میشود، روشی است که با حذف داده افزونه، نیازهای ذخیره سازی کاهش مییابد. علاوه بر کاهش مصرف فضای ذخیره سازی، هنگام انتقال داده تحت شبکه، تعداد بایتهای ارسالی نیز کاهش مییابد. این روش با نامهای دیگری مانند فشردهسازی هوشمند – Intelligent Compression و Single Instance Storage یا SIS نیز شناخته میشود.

SIS یک قابلیت سیستمی است که تنها یک نسخه از مطلبی که چندین کاربر یا کامپیوتر به اشتراک گذاشتهاند را نگه میدارد. یعنی دادههای تکراری حذف میشود تا کارایی افزایش یابد. SIS در سیستمهای فایلی، نرمافزار ایمیل سرور، بکاپ گیری از داده و دیگر نرمافزارهای مبنی بر ذخیره سازی استفاده میشود.

فشرده سازی هوشمند یا Intelligent Compression الگوهای افزونه را از داده حذف میکند تا کارایی اپلیکیشن بهبود یابد. این تکنیک معمولا در اپلیکیشنهای تحت وب استفاده میشود تا پهنای باند کمتری نیاز باشد و زمان پاسخ به کاربر کاهش یابد.

Dedupe یک قابلیت سیستمی است که تنها یک نسخه از مطلبی که چندین کاربر یا کامپیوتر به اشتراک گذاشتهاند را نگه میدارد. این روش، الگوهای افزونه را از داده حذف میکند تا کارایی بهبود یابد. کاربرد Data Deduplication معمولا در اپلیکیشنهای تحت وب است تا پهنای باند کمتری نیاز باشد و زمان پاسخ به کاربر کاهش یابد. همچنین در سیستمهای فایلی، نرمافزار ایمیل سرور، بکاپ گیری از داده، Snapshotهای بکاپگیری، نرمافزارهای مبتنی بر ذخیره سازی، مجازی سازی و VDI (زیرساخت دسکتاپ مجازی) استفاده میشود.

مزایای Data Deduplication

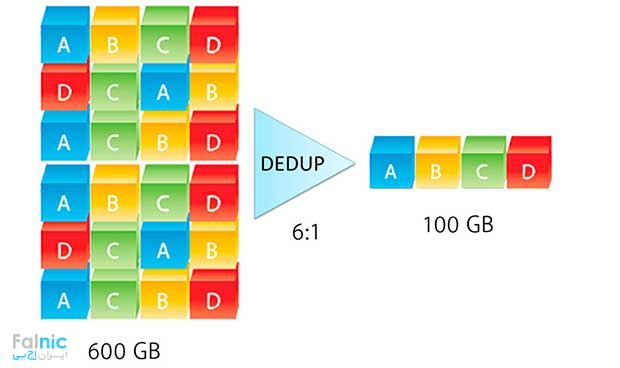

در تکنیک Data Deduplication طی یک پروسه تحلیلی، تنها یک نمونه از داده در رسانه ذخیرهسازی مانند Tape یا دیسک ذخیره میشود و داده افزونه یا تکراری با اشارهگری جایگزین میشود که به این نسخه از داده که یکتاست ارجاع میدهد. در نتیجه میزان دادهای که باید منتقل یا ارسال شود، به صورت چشمگیری کاهش پیدا میکند. مثلا یک ایمیلِ سیستمیِ معمولی ممکن است صد نمونه از یک فایل پیوست یک مگابایتی داشته باشد. برای بکاپگیری و آرشیو آن باید تمامی صد نمونه ذخیره شوند که به فضای ذخیرهسازی 100 مگابایتی نیاز دارد. اما با استفاده از Dedupe تنها یک نمونه از این فایل ذخیره میشود و نمونههای بعدی به همان یک نسخه ذخیره شده، ارجاع داده میشوند. در این مثال، هر صد مگابایت مورد نیاز میتواند به تنها یک مگابایت کاهش یابد.

Data Deduplication مزایای دیگری هم دارد. اگر به فضای ذخیرهسازی کمتری نیاز باشد، هزینه مالی مورد نیاز برای تامین دیسکها هم کاهش مییابد. استفاده بهینهتر از فضای دیسک، باعث افزایش زمان نگهداری دیسک میشود در نتیجه RTO بهتری نیز فراهم شده و نیاز به بکاپگیری نیز کمتر میشود. با استفاده از حذف رکوردهای تکراری داده بین 30 تا 95 درصد فضای کمتری برای ذخیره اطلاعات لازم داریم.

با Data Deduplication، دادههایی که باید در WAN به منظور بکاپگیری از راه دور، Replication و Disaster Recovery فرستاده شود نیز کاهش مییابد در نتیجه به پهنای باند کمتری نیز نیاز دارید و باعت بهینگی در WAN میشود. این تکنولوژی اغلب به صورت ترکیبی با دو تکنولوژی دیگر یعنی فشردهسازی و Delta Differencing استفاده میشود که در این صورت در بهینهسازی مصرف فضای ذخیرهسازی نیز موثرتر خواهد بود.

بیشتر بدانید: استوریج چیست

استفاده ار زیرساخت های دسکتاپ مجازی – VDI از راهکارهای استفاده از Data Deduplication است که پیاده سازی و تجمیع برنامهها، و دسترسی ریموت از مزایای آن است. برنامههای بکاپگیری مجازی هم از دیگر راهکارهای استفاده از Data Deduplication است زیرا بین اسنپ شات ها کار حذف رکوردهای تکراری را انجام میدهد.

انواع تکنیک Data Deduplication

دو تکنیک Data Deduplication عبارتند از Inline Deduplication و Post processing Deduplication. برای اینکه کارکرد این دو تکنیک را متوجه شویم آنها را با هم مقایسه میکنیم.

Inline Deduplication یعنی داده تکراری را وقتی دیتا در حال ارسال از یک دستگاه به دستگاه دیگر (معمولا سیستم بکاپ دیتا) است، حذف میکنیم. بدین ترتیب داده اضاقی حذف شده و ذخیره سازی بهینهتر انجام میشود. در این فرآیند لازم است پردازشی بین سرورهای داده و مقصد بکاپ داده انجام شود. Post processing Deduplication یعنی بعد از اینکه دیتا منتقل شد، داده تکراری حذف میشود. در نتیجه Inline Deduplication سرعت بکاپ گیری را کم میکند اما دیتای نهایی فاقد هر گونه دیتای بیمصرف و تکراری است.

برای تعمیر لپ تاپ خود روی لینک تعمیر لپ تاپ بزنید.

Data Deduplication در سطح بلاک و فایل

Data Deduplication در سطح بلاک یا فایل عمل میکند. File Deduplication فایلهای تکراری را حذف میکند اما کارایی زیادی ندارد. Block Deduplication بلاکهای تکراری را حذف میکند، روشی کاراتر است اما به قدرت پردازشی بیشتری نیاز دارد.

مزیت Data Deduplication در سطح فایل مصرف منابع (CPU و رم) کمتر است و قابل پیاده سازی روی فضای ذخیره سازی فیزیکی بزرگ است اما عیب مهم آن این است که نمیتواند Chunkهای تکراری کوچکتر از فایل را حذف کند.

مزیت Data Deduplication در سطح بلاک این است که میتواند Chunkهای تکراری کوچکتر از فایل را حذف کند اما عیب مهم آن این است که قابل پیاده سازی روی فضای ذخیره سازی فیزیکی بزرگ نیست. اگر منابع پردازشی کافی دارید، روش بسیار بهتری نسبت به Data Deduplication در سطح فایل است.

Data Deduplication در سطح target و source

source deduplication یعنی حذف داده تکراری در کلاینت اتفاق میافتد این کلاینت ممکن است سرور یا ورک استیشن یا پی سی باشد اما SAN یا NAS نیست. مزیت این روش این است که پهنای باند LAN کمی لازم است اما منابع بیشتری از کلاینت لازم دارد.

target deduplication یعنی حذف داده تکراری در رسانه بکاپ اتفاق میافتد. مزیت این روش این است که پهنای باند LAN بیشتری لازم است اما منابع کمی از کلاینت لازم دارد. این تکنیک در intelligent disk targets – IDTs و virtual tape libraries – VTL استفاده میشود. برای حجم بالای دیتا مثلا چندترابایت، اگر چه این روش نیاز به فضای ذخیره سازی بیشتری است اما کارایی و سرعت بیشتری دارد و برای شرکتهایی که پهنای باند کم و دیتای بیشتری هستند مناسب است.

انجام دیداپلیکیشن در منبع برای بکاپگیری برای دفاتر راه دور و شعبات مناسب است تا بکاپ ها به دیتاسنتر یا کلود منتقل شوند. دیداپلیکیشن در مقصد برای دیتاسنترها مناسب است چون حجم دیتای بسیار زیادی دارند.

خلاصه این مقاله

حذف رکوردهای تکراری داده (Deduplication) با نگهداری تنها یک نسخه از داده و جایگزینی موارد تکراری با اشارهگر، فضای ذخیرهسازی و پهنای باند شبکه را بهینهسازی میکند. این روش تا ۹۵ درصد فضای ذخیرهسازی را کاهش داده و هزینهها را کم میکند. برای پیادهسازی این تکنولوژی، راهکارهای عملیاتی زیر وجود دارد: ۱. **Inline Deduplication:** حذف دادههای تکراری حین انتقال (مثلاً به سیستم بکاپ) انجام میشود تا ذخیرهسازی بهینه و فوری صورت گیرد. ۲. **Post-processing Deduplication:** حذف تکرارها پس از انتقال داده انجام میشود. ۳. **Block-level Deduplication:** بلاکهای تکراری حذف میشوند که کارایی بالاتری دارد اما به قدرت پردازشی بیشتری نیاز دارد و برای حجمهای بزرگ داده توصیه میشود. ۴. **Source Deduplication:** حذف دادههای تکراری در سمت کلاینت (سرور یا ورکاستیشن) اتفاق میافتد که پهنای باند شبکه محلی را کاهش میدهد و برای دفاتر راه دور مناسب است. ۵. **Target Deduplication:** حذف دادههای تکراری در رسانه بکاپ (مانند VTL) انجام میشود که منابع کلاینت را آزاد میکند و برای دیتاسنترها با حجم بالای داده ایدهآل است. این روشها به کاهش نیاز به بکاپگیری، بهینهسازی WAN و بهبود RTO کمک میکنند.

در بسیاری از موارد فایل های تکراری خیلی زیادی در فضای ذخیره سازی وجود دارند که با کاهش اونها و حذف رکوردهای تکراری میشه هزینه های فضا رو به شدت کاهش داد.

درود بر شما

اکبری عزیز، ممنونیم از اینکه نظر خودتان را با ما به اشتراک می گذارید.

قابلیت بسیار مفید و پرکاربردی است

درود بر شما

رحمتی عزیز، ممنونیم از اینکه نظر خودتان را با ما به اشتراک می گذارید.

در واقع Data Deduplication به مدیران Storage کمک میکند تا هزینههای مرتبط با دادههای تکراری را کاهش دهند.

درود بر شما

روشندل عزیز، ممنونیم از اینکه نظر خودتان را با ما به اشتراک می گذارید.

با این تفاسیر فکر میکنم فضای هدر رفت دیگر بوجود ندارد.

درود بر شما

یوسفی عزیز، ممنونیم از اینکه نظر خودتان را با ما به اشتراک می گذارید.