کارت گرافیک مناسب برای هوش مصنوعی چه ویژگیهایی دارد؟

مباحثی مانند یادگیری عمیق و مدلهای زبانی عظیم AI به سرعت در حال گسترشاند. این موضوع باعث شده تا انتخاب کارت گرافیک مناسب برای هوش مصنوعی اهمیت زیادی پیدا کند. این روزها کارت گرافیک سرور صرفاً یک سختافزار گرافیکی نیست، بلکه در دیتاسنترها به قطعهای ضرور در سیستمهای آموزش و استنتاج AI تبدیل شده است. در این مقاله ویژگیهای اصلی یک GPU مناسب برای کاربردهای AI را مورد بررسی قرار دادهایم. با فالنیک همراه باشید.

فهرست محتوا

مشخصات اصلی کارت گرافیک مناسب برای هوش مصنوعی

در مقاله راهنمای انتخاب کارت گرافیک برای سرور، ویژگیهای مهم مدلهای مناسب برای استفاده در سرور و دیتاسنتر را بررسی کردیم. اما برای سرور هوش مصنوعی، اغلب از کارتهای گرافیکی حرفهایتر و قدرتمندتر استفاده میشود. این کارتها برای پردازش موازی و اجرای عملیات پرسرعت روی دادههای گرافیکی و محاسبات علمی قوی طراحی شدهاند. با توجه به نیازهای سرور هوش مصنوعی، موارد زیر باید در نظر گرفته شوند:

قدرت پردازش (Compute Performance)

توان پردازشی مهمترین معیار در انتخاب کارت گرافیک برای هوش مصنوعی است. این توان معمولاً برحسب ترافلاپس (TFLOPS) اندازهگیری میشود و نشان میدهد GPU در هر ثانیه چند تریلیون عملیات محاسباتی انجام میدهد. کارت گرافیکهای حرفهای سرور با هزاران هسته CUDA یا Stream Processor، قدرتی فراتر از صدها ترافلاپس ارائه میدهند. در آموزش مدلهای یادگیری عمیق، هرچه توان محاسباتی بالاتر باشد، سرعت همگرایی مدل افزایش مییابد و زمان آموزش کاهش مییابد.

علاوه بر توان خام، پشتیبانی از محاسبات ماتریسی (Tensor Operations) اهمیت زیادی دارد، زیرا بیشتر الگوریتمهای AI بر پایه ضرب ماتریسی طراحی شدهاند. وجود Tensor Core (در NVIDIA) یا Matrix Core (در AMD) باعث افزایش چندبرابری راندمان در آموزش مدلها میشود. همچنین پشتیبانی از FP16 و FP8 برای محاسبات با دقت پایینتر ولی سرعت بیشتر، یکی از الزامات اصلی کارتهای AI مدرن است.

ظرفیت و پهنای باند حافظه (VRAM / Memory Bandwidth)

حافظه گرافیکی یا VRAM تعیین میکند که چه مقدار داده، وزن مدل و دیتاهای آموزشی میتواند بهطور همزمان در GPU نگهداری شود. برای مدلهای بزرگ، حافظه کمتر از 24 گیگابایت بهسرعت اشباع میشود و باعث بروز خطای Out of Memory میشود.

در GPUهای مخصوص AI از حافظههای HBM2e یا HBM3 استفاده میشود که پهنای باند بسیار بالایی دارند (تا بیش از 3 ترابایت در ثانیه). این پهنای باند بالا برای انتقال سریع داده بین حافظه و هستههای پردازشی حیاتی است. در مقابل، کارتهای معمولی از حافظهی GDDR6 یا GDDR6X استفاده میکنند که سرعت پایینتری دارد.

علاوه بر ظرفیت و پهنای باند، توپولوژی حافظه نیز اهمیت دارد؛ کارتهایی با NVLink یا Infinity Fabric میتوانند حافظه چند GPU را با یکدیگر به اشتراک بگذارند و بهصورت خوشهای مدلهای بزرگتر از ظرفیت یک GPU را آموزش دهند.

دقت محاسبات (Precision Performance)

در هوش مصنوعی، بالاترین دقت ریاضی همیشه هدف اصلی نیست، بلکه توازن میان دقت و سرعت اهمیت دارد. GPUهای مدرن قابلیت انجام محاسبات در دقتهای مختلف مانند FP32، FP16، BF16، FP8 و INT8 را دارند.

برای مرحلهی آموزش مدل (Training) معمولاً از FP16 یا BF16 استفاده میشود تا عملکرد چندبرابر سریعتر از FP32 حاصل شود، درحالیکه افت دقت قابلتوجهی رخ ندهد. برای استنتاج (Inference)، کارتهایی که از INT8 پشتیبانی میکنند بسیار کارآمدترند، چون عملیات سادهتر و سریعتر انجام میشود.

کارتهای معمولی گرافیکی معمولاً تنها روی FP32 تمرکز دارند، اما GPUهای مخصوص AI مانند برای چند سطح از دقت بهینهسازی شدهاند و میتوانند به صورت خودکار بین فرمتها سوییچ کنند. این قابلیت باعث افزایش بازده، کاهش توان مصرفی و بهینهسازی بار کاری در انواع مدلهای یادگیری عمیق میشود.

دفع حرارت و مدیریت انرژی (Cooling & Power Efficiency)

توان مصرفی کارتهای مخصوص هوش مصنوعی معمولاً بسیار بالاست (بین 300 تا 700 وات در هر کارت). اگر سیستم خنککننده مناسب وجود نداشته باشد، عملکرد GPU به دلیل Thermal Throttling (گلوگاه حرارتی) کاهش مییابد. در محیطهای سروری، معمولاً از خنکسازی مایع (Liquid Cooling) یا طراحیهای خاص رکمونت (مثل HPE Cray یا NVIDIA DGX) استفاده میشود.

کارتهای مدرن با بهرهگیری از سنسورهای حرارتی هوشمند، سرعت فن یا پمپ مایع را بهصورت پویا تنظیم میکنند تا دما در محدوده بهینه باقی بماند. علاوه بر خنکسازی، راندمان انرژی (Performance per Watt) نیز اهمیت دارد. این مورد در مراکز داده با هزینه برق بالا، عامل تعیینکنندهای است.

فناوریهای پیشرفته و قابلیتهای نرمافزاری (Advanced Technologies)

کارتهای گرافیک هوش مصنوعی تنها به سختافزار قوی محدود نمیشوند؛ اکوسیستم نرمافزاری آنها اهمیت زیادی دارد. فناوریهایی مانند NVIDIA NVLink و AMD Infinity Fabric امکان اتصال چندین GPU با پهنای باند داخلی بالا را فراهم میکنند. NVIDIA MIG (Multi-Instance GPU) نیز اجازه میدهد یک GPU به چند بخش منطقی تقسیم شود و بهصورت همزمان برای چند کاربر یا فرآیند مورد استفاده قرار گیرد.

در سطح نرمافزار، پشتیبانی از چارچوبهای CUDA، cuDNN، ROCm، TensorRT و PyTorch/XLA تضمین میکند که GPU با ابزارهای محبوب یادگیری ماشین کاملاً سازگار است. همچنین کارتهای حرفهای از قابلیتهای امنیتی و مدیریت از راه دور برای دیتاسنترها پشتیبانی میکنند.

مقیاسپذیری و اتصال چند پردازنده گرافیکی (Scalability & Multi-GPU Interconnect)

در پروژههای بزرگ هوش مصنوعی، یک GPU بهتنهایی کافی نیست. کارتهای AI پیشرفته از فناوریهایی مانند NVLink، NVSwitch، PCIe Gen5 یا CXL برای ارتباط سریع بین چند GPU بهره میبرند. این فناوریها امکان توزیع حجم داده و مدل را میان چند کارت فراهم میکنند تا آموزش مدلهای تریلیونپارامتری ممکن شود.

GPUهایی که از اتصال چندگانه پشتیبانی میکنند، میتوانند در خوشههای HPC یا سرورهای DGX بهصورت یکپارچه کار کنند و مقیاسپذیری افقی بالایی ارائه دهند.

برخی مدلهای کارت گرافیک مناسب برای هوش مصنوعی

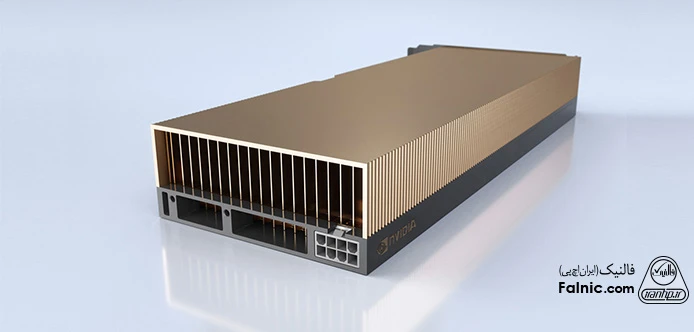

میتوان گفت که در صنعت تولید کارتهای گرافیک AI، انویدیا حرف اول را میزند. بهخصوص کارت گرافیکهای NVIDIA H100 94GB و NVIDIA H100 80GB با ویژگیهایی مانند حافظه HBM3 با پهنای باند عالی و پشتیبانی از فناوریهای پیشرفته (مانند NVLink) از قدرتمندترین مدلهای موجود در بازار هستند. کارت گرافیک Instinct MI300X نیز با بهره بردن از معماری CDNA3 و 192GB حافظه HBM3، یکی از مدلهای پرچمدار برای بارهای کاری AI و HPC به شمار میآید. در مقاله بهترین کارت های گرافیک برای سرور میتوانید با این مدلها بیشتر آشنا شوید.

آنچه درباره کارت گرافیک مناسب برای هوش مصنوعی یاد گرفتیم

کارت گرافیک، اصلیترین قطعه در آموزش مدلهای هوش مصنوعی و محاسبات پیچیده است و بهخصوص در سالهای اخیر، نقش پررنگی در دیتاسنترهای بزرگ پیدا کرده است. در این مقاله ویژگیهای اصلی کارت گرافیک مناسب برای هوش مصنوعی را مورد بررسی قرار دادیم و چند مدل از این GPUها را به شما معرفی کردیم. درصورتیکه برای انتخاب کارت گرافیک AI به مشاوره تخصصی نیاز دارید، میتوانید با شماره 8363-021 تماس بگیرید و با کارشناسان ما در ارتباط باشید.